Es una pregunta crucial que merece una reflexión profunda. Para empezar, es importante señalar los límites a la Inteligencia Artificial parecen cambiantes y está aún lejos de alcanzar un nivel de autoconciencia como para establecer unos limites definitivos que no afecten lo que realmente crea el ser humano.

La IA ya está en todo. Tanto así, que ya se encuentra como uno de los principales mercados para invertir en bolsa. Cerca del 85% de las empresas europeas y estadounidenses piensan que la Inteligencia Artificial debe ser prioridad en el desarrollo de tu negocio. Por esta razón, un 35% de estas mismas entidades ya la utilizan de manera directa o indirecta.

Inteligencia Artificial hasta en el aire

Hoy en día, lo que llamamos IA no es más que un conjunto de técnicas avanzadas diseñadas para emular ciertas facetas de lo que conocemos como «inteligencia«. Estas técnicas abarcan desde el reconocimiento de patrones hasta la optimización de soluciones para problemas específicos, utilizando herramientas como redes neuronales, algoritmos evolutivos, entre otras.

Ahora bien, cuando se habla de términos como «redes neuronales» esto puede resultar engañosos. Aunque toman inspiración de ciertas características biológicas, como las neuronas del cerebro o los procesos evolutivos, no se acercan a replicar estas complejidades a gran escala.

Las aplicaciones actuales de la IA operan en escalas relativamente pequeñas y controladas, muy lejos de lo necesario para construir una máquina realmente consciente. Para algo comparable a la inteligencia humana, necesitaríamos infraestructuras tecnológicas de una magnitud que hoy no existe.

¿Dónde está realmente el problema?

El problema no reside tanto en la tecnología en sí, sino en cómo se utiliza y en la supervisión que se le asigna. A lo largo de la historia, es común encontrar voces que culpan a la tecnología de los errores humanos. Este fenómeno, conocido desde tiempos del ludismo, sigue vigente. Si algo falla, es más fácil culpar a la herramienta que asumir la responsabilidad de una implementación deficiente o de una falta de supervisión adecuada.

Por ejemplo, pensemos en un sistema para controlar la temperatura en una sala de incubadoras para bebés prematuros. Este sistema puede incluir sensores avanzados que monitoricen la temperatura, la humedad y otros factores críticos, ajustándolos automáticamente dentro de ciertos límites. Sin embargo, en situaciones críticas, es esencial la supervisión humana. Si un error no se detecta porque nadie está monitoreando adecuadamente el sistema, la culpa no es del programa, sino de quienes delegaron completamente la responsabilidad en una máquina.

Además, en tecnologías como las redes neuronales, donde el funcionamiento interno a veces resulta opaco incluso para los expertos, los comportamientos inesperados son una posibilidad. Esto no significa que la máquina «se rebele», como en las narrativas de ciencia ficción tipo Skynet, sino que el sistema responde de acuerdo a los parámetros que se le han proporcionado, aunque estos no siempre reflejen todas las variables del mundo real. La solución es garantizar siempre la intervención humana en situaciones críticas.

Estableciendo límites responsables

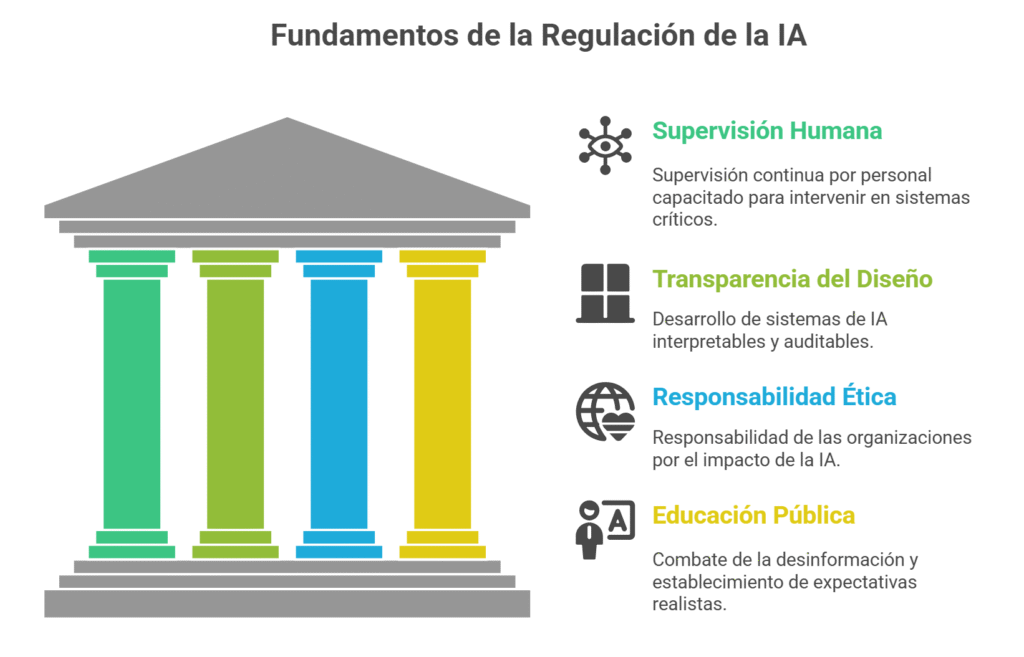

Más que prohibir el avance de la IA, deberíamos enfocarnos en regular su uso para garantizar que se desarrolle de manera ética y responsable. Esto incluye:

- Supervisión constante: Todo sistema crítico debe ser supervisado por personas capacitadas que puedan intervenir en caso necesario.

- Transparencia en el diseño: A medida que la IA se vuelve más compleja, es esencial que los desarrolladores trabajen en sistemas más interpretables y auditables.

- Ética y responsabilidad: Las organizaciones que diseñan y despliegan sistemas de IA deben asumir responsabilidad por su impacto y garantizar que estos se utilicen para el beneficio de la humanidad.

- Educación pública: Es fundamental combatir la desinformación y las expectativas poco realistas sobre lo que la IA puede y no puede hacer.

Los límites para nosotros

La IA es una herramienta poderosa que refleja la intención de quienes la diseñan y operan. Si cometemos errores en su uso, la culpa no es de las máquinas, sino nuestra. Supervisar, aprender y evolucionar con responsabilidad es la clave para un futuro donde la tecnología y la humanidad trabajen en armonía.